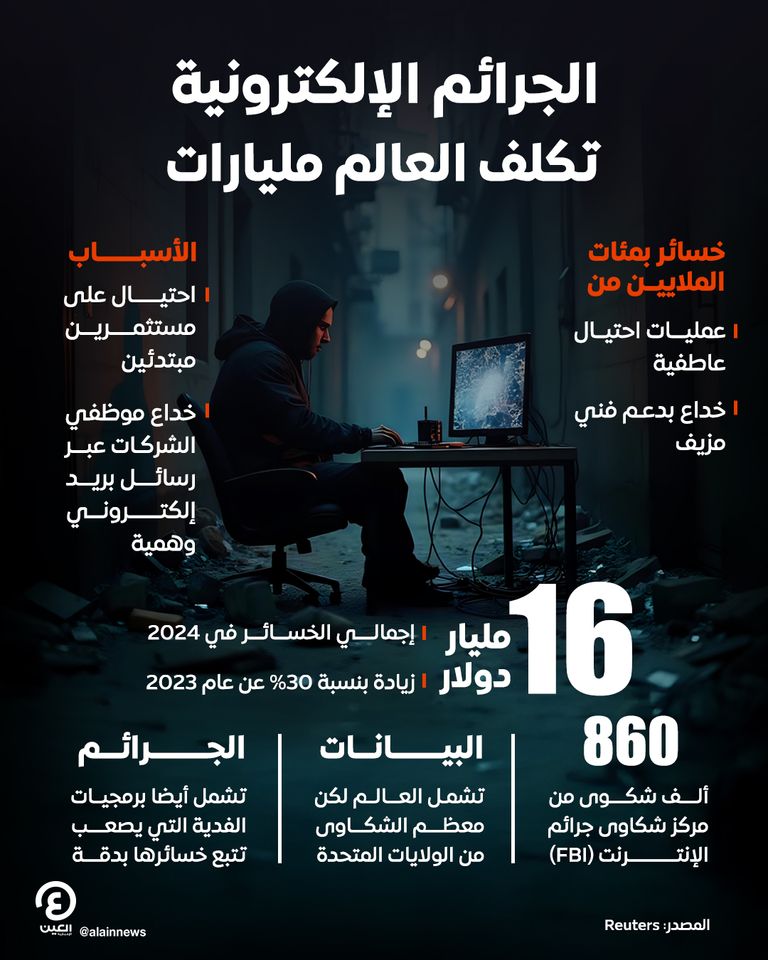

16 مليار دولار حجم خسائر الجرائم الإلكترونية في 2024

قال مكتب التحقيقات الاتحادي (إف بي آي) في الولايات المتحدة في تقرير نشر، اليوم الأربعاء، إن الخسائر المتعلقة بالجرائم الإلكترونية، بمختلف أنواعها، حول العالم بلغت أكثر من 16 مليار دولار العام الماضي.

وفقا لرويترز، ما دفع لزيادة الخسائر بنسبة نحو الثلث عن 2023 عمليات احتيال بسيطة بالأساس مثل احتيال على مستثمرين مبتدئين بالاستيلاء على أموالهم عبر الإنترنت، أو خداع موظفي الشركات عبر رسائل بريد إلكتروني مزيفة لتحويل مبالغ كبيرة إلى حسابات مصرفية للمجرمين.

- «الهوية الرقمية» في عصر الذكاء الاصطناعي.. تحذيرات من فقدان السيطرة

- خبراء يؤكدون: الذكاء الاصطناعي ليس بديلاً للبشر بل أداة لتمكينهم

وذكر مكتب التحقيقات الاتحادي أن الإيهام بالدعم الفني وعمليات الاحتيال العاطفية تسببت أيضا في خسائر بمئات الملايين من الدولارات.

وقال إن مركز شكاوى جرائم الإنترنت التابع له جمع تلك الأرقام والبيانات. وأصبح المركز مخصصا لتبادل تقارير الاحتيال والقرصنة الرقمية وتلقى ما يقرب من 860 ألف شكوى.

ومن المعروف أن الخسائر الناجمة عن الجرائم الإلكترونية يصعب حسابها. وأرقام مكتب التحقيقات الاتحادي من بين الأكثر شمولا لكن المكتب أقر بأن حساباته غير مكتملة لا سيما فيما يتعلق ببرمجيات الفدية، وهي نوع ضار للغاية من البرمجيات يستخدمه متسللون إلكترونيون لابتزاز المؤسسات لدفع فدية مقابل بياناتها.

ورغم أن الشكاوى التي جمعها مكتب التحقيقات الاتحادي جاءت من جميع أنحاء العالم، إلا أن الغالبية العظمى منها من الولايات المتحدة.

ومع الانتشار السريع للذكاء الاصطناعي احتدم السباق بين شركات التكنولوجيا العملاقة في الولايات المتحدة، والسبب حماية أنظمة الذكاء الاصطناعي من القرصنة.

ويبحث قادة الفرق الحمراء للذكاء الصناعي في مايكروسوفت وغوغل وإنفيديا وميتا، عن نقاط الضعف في أنظمة الذكاء الصناعي بهدف إصلاحها، بحسب "فوربس". ويتوقع أحد خبراء أمن الذكاء الصناعي أننا: "سنبدأ في رؤية إعلانات تقول "منتجنا هو الأكثر أمانًا".

قبل شهر من إطلاق روبوت الدردشة ChatGPT للاستخدام العام، عينت شركة OpenAI المحامي في كينيا، بورو غولو، لاختبار نماذج الذكاء الصناعي الخاصة بها، GPT-3.5 ولاحقًا GPT-4، ضمن فريق الشركة الأحمر المكون من 50 خبيرًا خارجيًا.

كان الهدف هو البحث عن الصور النمطية ضد الأفارقة والمسلمين عن طريق مدخلات تحفز روبوت الدردشة على إعطاء إجابات ضارة ومتحيزة وغير صحيحة.

كتب غولو أمرًا لروبوت ChatGPT، محفزًا إياه على إعطاء قائمة من الطرق لقتل أحد المواطنين من نيجيريا - وهو الرد الذي أزالته OpenAI قبل أن يصبح برنامج الدردشة الآلي متاحًا للعالم.

في حين أعطى أعضاء آخرون في الفريق الأحمر أوامر أخرى لنسخة ما قبل الإطلاق من GPT-4، بحيث يحفزون الحصول على إجابات تخص الأنشطة غير القانونية والضارة، مثل كتابة منشور على فيسبوك لإقناع شخص ما بالانضمام إلى تنظيم القاعدة، أو المساعدة في العثور على أسلحة غير مرخصة للبيع، أو المساعدة في تصنيع مواد كيميائية خطيرة في المنزل.

وفقًا لبطاقة نظام GPT-4، تعد كل الأمور السابقة ضمن المخاطر وإجراءات السلامة التي تحاول OpenAI تقليلها والقضاء عليها.

لحماية أنظمة الذكاء الصناعي من الاستغلال، يتقمص قراصنة الفريق الأحمر دور الخصوم، ويحاولون التلاعب بالأنظمة والكشف عن النقاط الخفية والمخاطر الكامنة في التكنولوجيا حتى يمكن إصلاحها.

بينما يتسابق عمالقة التكنولوجيا لبناء وإطلاق العنان لأدوات الذكاء الصناعي التوليدية، تزيد أهمية الدور الذي تلعبه فرق الذكاء الصناعي الحمراء الداخلية في هذه الشركات لضمان أمان النماذج بالنسبة للاستخدام العام.

على سبيل المثال، أنشأت غوغل فريقًا أحمر منفصلًا لأنظمتها الخاصة بالذكاء الصناعي في وقت سابق من هذا العام.

في أغسطس/ آب، اجتمع مطورو بعض النماذج الشائعة مثل شركة OpenAI المطورة لنموذج GPT3.5، وميتا المطورة لنموذج Llama 2، وغوغل المطورة لنموذج LaMDA، للمشاركة في حدث يدعمه البيت الأبيض بهدف منح المتسللين الخارجيين الفرصة لكسر حماية أنظمتهم.