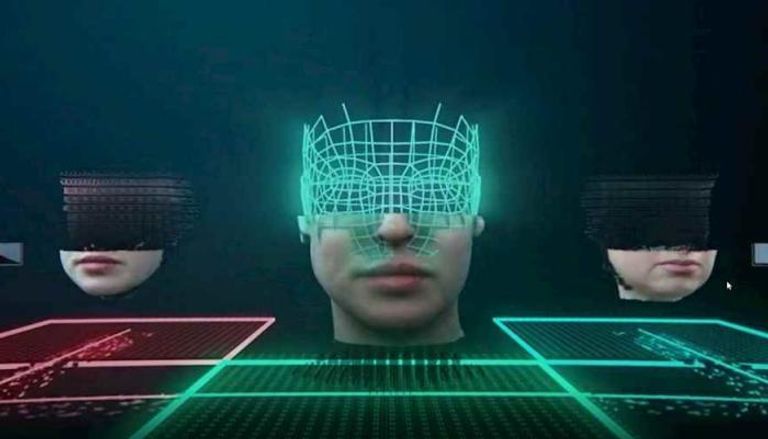

الخداع العميق.. الوجه القبيح لـ"الذكاء الاصطناعي"

أبدى باحثون قلقهم إزاء استخدام تقنية محاكاة صوت وصورة الشخصيات المهمة في الجريمة والإرهاب

تصدرت تقنية الخداع العميق المعروفة بـ"Deep fake" صدارة الحلول التكنولوجية التي تستخدم إمكانيات الذكاء الاصطناعي الهائلة في مجالات الجريمة والإرهاب.

وتعتمد هذه التقنية المتطورة على تطوير فيديوهات تنطوي على مقابلات ومواقف ومشاهدات وأحداث غير حقيقية بالمرة، خاصة فيما يتعلق بمحاكاة خصائص المشاهير بدقة كبيرة جدا لدرجة يصعب اكتشافها، وتوظيفها في فيديوهات مزيفة تتحدث عن مواقف أو قضايا غير حقيقية.

وأفادت دراسة حديثة أجرتها كلية لندن بين 31 خبيرا بالذكاء الاصطناعي بشأن 20 طريقة ذكية سيتم استخدامها في ارتكاب الجرائم خلال الخمسة عشر عاما القادمة، بأن تقنية الخداع العميق هي الأكثر إثارة للقلق، بناء على تقييمات حجم الضرر الناجم عنها وسهولة الاستخدام وصعوبة إيقاف المجرمين.

وبحسب الدراسة فإن المحاكات المرتفعة للشخصيات صوت وصورة سيفقد الناس الثقة بالأدلة السمعية والبصرية، لا سيما أنه يمكن استخدامها في جرائم تشويه سمعة الشخصيات العامة، وانتحال هوية بعض الشخصيات للاستيلاء على أموال الجمهور.

وضربت كلية لندن مثالا بانتشار فيديو مفبرك لنانسي بيلوسي رئيسة مجلس النواب الأمريكي، تبدو فيه مخمورة للغاية.

ومن أجل تنفيذ هذا الخداع بدرجة احترافية عالية يتم دراسة نمط حديث لأي شخصية من حركات الوجه ولغة الجسد، ثم محاكاة نبرة الصوت باستخدام قاعدة عريضة من التسجيلات الصوتية، ثم تطوير حديث كامل مزيف لهذه الشخصية.

وتكمن خطورة الخداع العميق أيضا في صعوبة رصد هؤلاء المجرمين، لكون آليات الكشف الآلي غير موثوق بها حتى الآن، بالتزامن مع استخدام هذه التكنولوجيا خوارزميات معقدة بحسب الخبراء.

وأكد الباحثون أن استخدام الأشخاص لتقنية الخداع العميق سيكون أكثر سهولة خلال السنوات المقبلة مع التطور التكنولوجي، وهو ما يثير المخاوف بشأن استغلالها مستقبلا في الجرائم.

وكما حددت الدراسة 5 أنماط من تهديدات الذكاء الاصطناعي، تشمل التصيد الاحتيالي، والأخبار المزيفة، حشد المعلومات الإلكترونية بغرض الابتزاز، شن هجمات على الأنظمة المُدارة عبر الذكاء الاصطناعي، واستخدام المركبات بدون قائد كأسلحة.

aXA6IDIxNi43My4yMTYuMTMg

جزيرة ام اند امز